Làm giả cuộc gọi video của người thân nhằm chiếm đoạt tài sản

Đời sống - Ngày đăng : 06:24, 31/03/2023

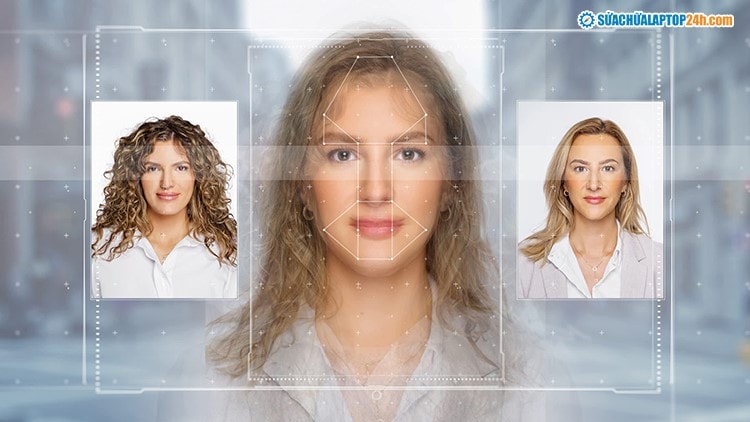

Deepfake là công nghệ ứng dụng trí tuệ nhân tạo (AI) tạo ra các sản phẩm công nghệ âm thanh, hình ảnh và video làm giả đối tượng ngoài đời thực với độ chính xác rất cao. Dựa trên tệp tin hình ảnh khuôn mặt, giọng nói của một người ngoài đời thực, Deepfake sẽ sử dụng thuật toán để tái tạo lại khuôn mặt và giọng nói phù hợp với nét mặt, biểu cảm của một người khác; sau đó tạo ra video giả mạo hoàn toàn đối tượng ngoài đời thực.

Thông qua mạng Internet, các đối tượng thu thập hình ảnh, giọng nói của người dùng trên mạng xã hội, sử dụng công nghệ Deepfake tạo ảnh động, video giả mạo người dùng đang nói chuyện trực tuyến với cùng khuôn mặt, âm điệu giọng nói và cách xưng hô.

Đối tượng tạo lập tài khoản giả mạo trên mạng xã hội trùng thông tin và ảnh đại diện với người dùng, kết bạn với nạn nhân trong danh sách bạn bè và nhắn tin vay mượn tiền theo kịch bản sẵn có. Trong một số trường hợp, đối tượng chiếm đoạt tài khoản mạng xã hội của người dùng để trực tiếp nhắn tin cho các nạn nhân trong danh sách bạn bè. Để tạo lòng tin với nạn nhân, đối tượng truyền tải Deepfake video sẵn có lên kênh video call, khiến nạn nhân nhận ra hình ảnh và giọng nói của người quen và nhanh chóng chuyển tiền theo yêu cầu của đối tượng.